Les « testing » maintenant si facile sur le Web

L’arme secrète des praticiens du marketing direct a toujours été l’utilisation de tests comparatifs dans le but d’améliorer ou d’optimiser les retombées de leurs campagnes et de minimiser le risque associé aux décisions qu’ils prennent.

En isolant des échantillons de taille identique et en leur présentant des offres, des messages, des formats ou des concepts différents, puis en comparant les résultats entre-eux, on est en mesure de déterminer avec une certaine précision lequel performe le mieux.

Il n’y a pas si longtemps, les tests comparatifs (aussi appelé test A/B split, de l’anglais split-run testing) étaient peu utilisés au niveau du Web en raison de la complexité apparente de les réaliser…et de la résistance des gens de IT qui considéraient la possibilité que quelque chose puisse exister en double, en triple ou en quadruple comme de l’hérésie.

Quoi qu’il en soit, l’oracle Google s’est prononcé en faveur des tests et a même créé un outil pour y parvenir: Google Web Optimizer. Ce merveilleux outil permet non seulement d’administrer les tests, mais aussi d’en gérer les conditions et d’élire le gagnant de façon entièrement automatisé.

Encore plus facile qu’avec les autres médias

Google Web Optimiser permet avec beaucoup de simplicité, de servir de multiples versions d’une page web dans le but d’optimiser le taux de conversion d’un formulaire, le taux d’interaction avec une page, le taux de clic sur un lien ou bouton, etc. Il suffit de créer les multiples variantes, puis de les soumettre au moteur de testing, pour effectuer le test.

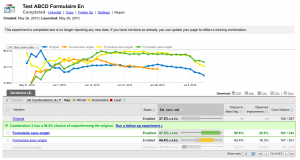

On voit le taux de conversion des quatre versions du formulaire fluctuer avec le temps. Ce qui semblait prometteur au tout début n'est pas un choix viable après quelques semaines de test.

Si vous n’êtes pas familier avec les conditions dans lesquelles vous devez effectuer vos tests, voici quelques règles à garder en tête:

1- ceteris paribus: toute chose étant égale par ailleurs.

Pour pouvoir tirer des conclusions, on ne doit tester qu’une seule variable à la fois. Alors si on change à la fois l’offre, le message et le design, on ne saura pas quel élément explique la hausse (ou la baisse) des résultats.

2- tester les choses qui auront le plus d’impact:

Lorsque vous commencez à faire des tests, rien ne sert de valider des différences subtiles. Vous devez rapidement trouver réponse à des questions fondamentales. Donc teste des choses qui risquent d’avoir un effet important sur les résultats – comme le design d’un formulaire. Sur les messages clés de votre page d’accueil. Sur les offres qui vous permettront d’augmenter rapidement votre taux de conversion et le nombre de commandes. Les subtilités viendront plus tard.

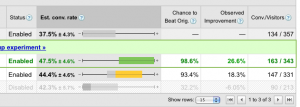

Google utilise ce tableau pour représenter graphiquement les intervalles de confiance et colore en vert le test gagnant.

3- n’oubliez-pas l’intervalle de confiance:

Juste parce que vous observez un résultat différent ne veut pas dire que c’est meilleur, ou pire. On ne peut déclarer un gagnant que si les intervalles de confiance sont mutuellement exclusives. Dans la saisie d’écran ci-dessous, on voit que le test « formulaire avec onglet » a un taux de conversion de 47,5% plus ou moins 4,6%. Cela veut dire que l’intervalle de confiance, c’est-à-dire la brochette de résultats possibles à chaque fois qu’on répète le test, varie de 42,9% à 52,1% alors que l’original (ce à quoi on compare les variantes) a un intervalle de 33.2% à 41.8%. Comme la limite supérieur de l’intervalle de confiance de l’original est de 41,8% et que la valeur inférieur du test « formulaire avec onglet » est de 42,9%, les intervalles ne se touchent pas. Donc le test est effectivement meilleur. Si les deux se chevauchaient, il est plausible que se soit du à une erreur d’échantillonnage et donc pas concluant.

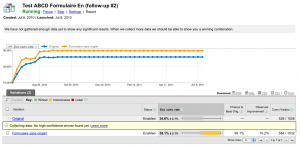

Test subséquent visant à confirmer la décision. Après plus de 3 000 conversions, il n'y a toujours pas de gagnant clair.

4- armez-vous de patience:

Plus l’écart est mince, plus ça prend de visiteurs pour valider votre test. Donc si l’achalandage de votre site est faible, il vous faudra plusieurs semaines pour pouvoir tirer vos conclusions. Et plus vous avez de variantes à tester, plus vous divisez votre trafic. Comme l’exemple ci-dessous le démontre très bien, on peut faire rouler un test pendant plusieurs semaines ou plusieurs mois sans pouvoir tirer des conclusions claires. Ici on a évalué 3 058 inscriptions dans la base de données et l’écart entre les deux test n’est pas suffisant pour dire que le résultat est concluant. Il faudra sans doute 5 000 conversions pour que l’intervalle de confiance soit suffisamment petit pour déclarer un gagnant.5- dès que vous avez terminé, recommencez:

Puisque les tests sont des estimations de la réalité, et que leur précision est toujours sujet à une erreur statistique (plus ou moins 5%, 9 fois sur 10, par exemple), il est toujours possible qu’il y ait eu une erreur. Adoptez vite le gagnant, mais assurez-vous de revalider les résultats pour être certain d’avoir pris la bonne décision.6- n’arrêtez jamais de tester:

Dès qu’on s’arrête, on perd du terrain. Il faut constamment chercher de nouveaux moyens d’améliorer les rendements. Chaque test nous permet d’étendre nos connaissances et de découvrir de nouvelles pistes. Des pistes qui mènent à de nouveaux tests et de nouvelles découvertes. C’est pour cela que le marketing relationnel est si passionnant.